워드프레스로 사이트를 개발하려면 실제 운영 사이트를 만들기 전에 로컬호스트에서 모든 작업을 마치고 웹호스팅이나 서버에 업로드 하는 것이 정상적인 방법입니다. 개발에 능숙한 분들은 바로 서버에서 작업을 할 수도 있습니다. 이럴 경우 콘텐츠가 자주 변경되는데 검색엔진은 한번 크롤링하고 인덱싱을 마치면 다음 크롤링까지 시간이 걸립니다. 만일 불완전한 상태에서 작업을 하면 일부 콘텐츠만 인덱싱 한 상태가 되므로 완전한 콘텐츠가 저장되지 않게 됩니다. 따라서 서버에서 직접 작업할 때는 검색엔진이 크롤링을 하지 못하도록 막아놓는 것이 좋습니다.

또한 로컬호스트에서 사이트가 완성돼 서버에 업로드하고 운영중일 경우 실제 사이트와 똑같은 테스트 사이트를 만들어 여러 가지 테스트를 할 필요도 있을 것입니다. 실제 운영되고 있는 사이트를 대상으로 플러그인 업데이트나 테마 업데이트 테스트를 하면 방문자에게 혼란을 초래할 수 있기 때문입니다. 자주 정지되기도 하고 에러가 발생하면 방문자가 사이트를 신뢰할 수 없게 됩니다. 이럴 경우에도 테스트 사이트를 만들어 테스트를 하면서 크롤링을 막아놓는 것이 바람직합니다.

크롤링을 막아놓는 이유는 똑같은 내용의 콘텐츠가 있으면 구글의 경우 페이지 랭크에서 불이익을 주기 때문입니다. 두 개 이상의 사이트가 똑같은 콘텐츠로 돼있다면 둘 중 어느것이 진짜인지 분간을 못하므로 둘다 불이익을 주게 됩니다. 인덱싱에서 제외되면 검색에서도 제외되게 됩니다.

가장 간단한 방법은 워드프레스의 기능을 이용하는 방법입니다.

워드프레스 관리자 화면의 설정 -> 읽기에서 검색 엔진 접근 여부의 "검색 엔진이 이 사이트 검색 차단하기"에 체크하면 알림판의 사이트 현황에서 "검색엔진이 차단됐습니다."라는 메시지가 출력됩니다. 이 기능이 활성화 되면 head 태그에 다음과 같은 메타 태그가 추가됩니다.

<meta name='robots' content='noindex,follow' />

검색엔진 크롤러인 로봇에게 인덱싱하지 말고 대신 팔로우는 하라는 지시입니다. 테스트를 해보니 이 설정만으로도 검색이 안되지만 위 체크박스 아래의 도움말인 "이 요청이 받아들여지는 것은 전적으로 검색 엔진에 좌우됩니다."라는 메시지도 그렇고 좀 불완전합니다. 보다 더 안전하게 하려면 수동으로 코드를 추가합니다.

header.php 파일의 head 태그 종료 직전에 위와 같이 추가합니다. 워드프레스로 검색엔진 차단 기능을 활성화 했다면 wp_head();에 의해 <meta name='robots' content='noindex,follow' />가 추가되므로 바로 아래에 추가하는 것입니다. 활성화하지 않았다면 head 태그 내부의 상단에 넣으면 됩니다. 위 코드에는 nofollow까지 추가됐습니다.

다른 방법으로는 robots.txt 파일을 이용합니다.

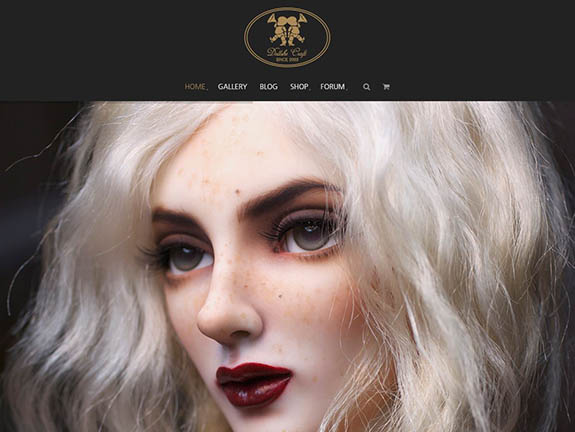

위 그림은 파일질라에서 리모트 서버의 루트 디렉토리를 캡처한 것입니다. 기본 워드프레스가 설치된 곳이고 여러 개의 워드프레스와 잡다한 것들이 서브 디렉토리에 설치돼있습니다. 예를들어 dollshe라는 서브 디렉토리에 워드프레스가 설치돼있고 이 사이트를 검색에서 제외하고자 한다면 robots.txt 파일을 루트에 만들고 이 파일을 열어서 그림처럼 디렉토리를 지정해주면 됩니다.

|

한가지 염두에 둘것은 워드프레스 사이트는 검색 엔진에 검색등록을 하지 않아도 검색 대상이 되도록 만들어졌습니다. 따라서 검색 등록을 해야 검색 대상이 된다는 생각은 버려야 합니다. 검색 등록 시에는 보다 구체적인 정보를 추가해주면 됩니다. 국내 검색엔진의 경우는 완전한 검색은 안되고 웹문서로만 검색됩니다. 사이트가 블로그라면 블로그로 검색등록을 하는 것이 좋습니다. 검색엔진은 블로그를 우선시 하니까요.